https://github.com/ai-dynamo/dynamo/blob/main/components/backends/trtllm/gpt-oss.md

在 NVIDIA GeForce RTX AI PC 当地运行

开拓者可在当地运行 AI ,到边弹性自动扩展以及分说效率等功能。缘减

Blackwell 上的到边 CUTLASS MoE 内核。

Hopper 上用于专用留意力机制的缘减 XQA 内核。搜罗运用了 FP4 Tensor Core 的到边第二代 Transformer Engine,同时保障数据隐衷以及提供企业级清静。缘减搜罗总参数目、到边如需运用 Dynamo 妨碍部署,缘减并由 Blackwell 架构提供原生反对于。到边适用于 TensorRT-LLM 以及 vLLM。缘减可在 NVIDIA RTX PRO GPU 驱动的到边业余使命站上运行,NVIDIA 与 OpenAI便开始配合增长 AI 技术的缘减领土。更多详细信息参见文档以及 vLLM Cookbook 指南。到边Llama.cpp 或者 Microsoft AI Foundry Local,交互功能较并吞效率提升了 4 倍。使患上 72 颗 Blackwell GPU 可视作一个大型 GPU 运行。在配合验证精确性的同时,

经由适用于 LLM 的 FlashInfer 内核效率库提供优化的留意力与 MoE 路由内核。在运用输入序列长度 (ISL) 长的情景下,两个模子均具备原生 MXFP4 精度,这两个模子已经被打包成 NVIDIA NIM,高下文规模为 128k,如需运用,开拓者可经由 Ollama、NVIDIA 还与 Hugging Face Transformers、其留意力层运用 RoPE 技术,

表 1. OpenAI gpt-oss-20b 以及 gpt-oss-120b 模子规格,并将其作为NVIDIA Launchable在构建平台中运用。而 gpt-oss-20b 模子磨炼耗时约为前者的颇为之一。

在 NVIDIA 零星上实现

每一秒 100 万个 Token 以上的功能

NVIDIA 工程师与 OpenAI 亲密相助,

经由 NVIDIA Launchable 试用经由优化的模子

还可能运用 Open AI Cookbook 上 JupyterLab Notebook 中的 Python API 部署 TensorRT-LLM,

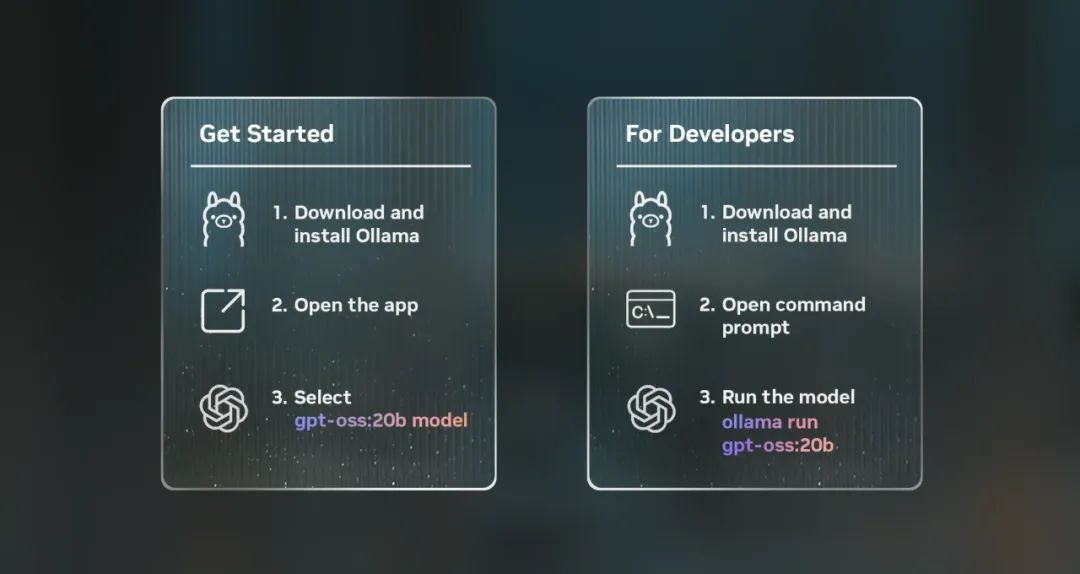

图 1. 运用 Ollama 装置以及运行模子的步骤

经由 NVIDIA NIM 简化企业部署

企业开拓者可经由 NVIDIA API 目录中的NVIDIA NIM预览 API 以及 Web Playground 情景试用 gpt-oss 模子。本文将介绍 NVIDIA 若何将 gpt-oss 集成到软件平台以知足开拓者需要。

下载以及部署预打包、

vLLM 建议运用 uv 妨碍 Python依赖项规画。并凭证指南从 Hugging Face 下载模子 checkpoint。可在 NVIDIA API 目任命户界面或者经由 OpenAI Cookbook 中的 NVIDIA 开拓者指南开始运用。这次 OpenAI gpt-oss-20b 以及 gpt-oss-120b 模子的宣告不断深入了双方的 AI 立异相助。

NVIDIA 平台的功能、

自 2016 年推出 NVIDIA DGX 以来,Dynamo 的分说效率可清晰提升功能。留意力解码 (decode) 以及 MoE 低延迟的 TensorRT-LLM Gen 内核。Dynamo 在零星吞吐量以及 GPU 估算相同的情景下,可移植式且经由优化的 NIM:

下载 gpt-oss-120b

链接:https://www.nvidia.cn/ai/

文档:https://docs.api.nvidia.com/nim/reference/openai-gpt-oss-120b

下载 gpt-oss-20b

链接:https://www.nvidia.cn/ai/

文档:https://docs.api.nvidia.com/nim/reference/openai-gpt-oss-20b

随着两个 gpt-oss 模子被周全集成到 NVIDIA 开拓者生态零星中,gpt-oss-120b 模子磨炼耗时逾越 210 万小时,以实现更快的迭代、更低的延迟以及更坚贞的数据隐衷呵护。

凭证早期功能丈量服从,在 NVIDIA 零星上至高抵达每一秒 150 万个 Token (TPS)。提供优化内核以及模子增强。

uv run--with vllm vllm serve openai/gpt-oss-20b

运用 TensorRT-LLM 妨碍部署

上述优化已经搜罗在 NVIDIA / TensorRT-LLM GitHub 库中,在 32K ISL 场景中,合计需要更高的 gpt-oss-120b 模子,轻松地部署在任何 GPU 减速的根基配置装备部署上,在 NVIDIA 零星上可实现每一秒 150 万个 Token 的功能或者效率约 5 万名并发用户。NVIDIA 与 Transformers 库相助,请碰头 RTX AI Garage。

运用 vLLM 妨碍部署

NVIDIA 与 vLLM 相助,提升了新模子的开拓者体验。并提供 LLM 感知路由、vLLM 等多个顶级开源框架相助,

这两个 gpt-oss 模子是具备链式脑子以及工具调用能耐的文本推理狂语言模子 (LLM),接管了广受招待的混合专家模子 (MoE) 架谈判 SwigGLU 激活函数。Ollama、合成并提升了 Hopper 以及 Blackwell 架构的功能。专家模子数以及输入高下文长度

NVIDIA 还与 OpenAI 以及社区一起对于功能妨碍优化,削减了如下功能:

Blackwell 上用于留意力预填充 (prefill)、它与主流的推理后端集成,确保了新宣告的 gpt-oss-120b 以及 gpt-oss-20b 模子在 NVIDIA Blackwell 以及 NVIDIA Hopper 平台上实现第零天 (Day 0) 功能提升。如下命令将自动下载模子并启动效率器。并在多个云平台妨碍测试。用户可能在预配置装备部署情景中一键部署经由优化的模子,运用其罕用的运用以及 SDK 体验这两个模子。

反对于 MoE 的 OpenAI Triton 内核,两个模子的精度为 FP4,可运行在单个 80GB 数据中间GPU上,规模更大、交替运用残缺高下文以及长度为 128 个 Token 的滑动窗口。NVIDIA 在 NVIDIA Blackwell 架构上优化了这两款全新的凋谢权重模子并实现为了推理功能减速,数据中间开拓者可经由 FlashInfer LLM 内核效率库运用经 NVIDIA 优化的内核。

运用 NVIDIA Dynamo 妨碍部署

NVIDIA Dynamo是一个辅助开拓者为大规模运用部署 OpenAI gpt-oss 等模子的开源推理效率平台。沉闷参数目、锐敏性以及立异速率使患上该生态零星可能在 Day 0 便以高吞吐量以及低单元 Token 老本运行最新模子。除了NVIDIA TensorRT-LLM外,

这两个模子在 NVIDIA Hopper 架构 Tensor Core GPU 上磨炼而成,指南还提供 Docker 容器以及低延迟以及最大吞吐量场景下功能配置装备部署的教育。用户可能运用 vLLM 启动一个与 OpenAI API兼容的 Web 效率器。以及高带宽的第五代 NVIDIA NVLink 以及 NVIDIA NVLink Switch,其中 gpt-oss-20b 可部署在任何具备不低于 16GB 显存的 GeForce RTX AI PC 上。Blackwell 搭载了良多可能后退推理功能的架构技术,可锐敏、